Cet article traite de certaines des façons d'explorer un site Web, y compris des outils d'exploration Web et de l'utilisation de ces outils pour diverses fonctions. Les outils abordés dans cet article incluent :

- HTTrack

- Cyotek WebCopie

- Saisie de contenu

- ParseHub

- Hub OutWit

HTTrack

HTTrack est un logiciel gratuit et open source utilisé pour télécharger des données à partir de sites Web sur Internet. C'est un logiciel simple d'utilisation développé par Xavier Roche. Les données téléchargées sont stockées sur localhost dans la même structure que sur le site Web d'origine. La procédure pour utiliser cet utilitaire est la suivante :

Tout d'abord, installez HTTrack sur votre machine en exécutant la commande suivante :

[email protected]:~$ sudo apt-get install httrackAprès avoir installé le logiciel, exécutez la commande suivante pour explorer le site Web. Dans l'exemple suivant, nous allons explorer astuce linux.com:

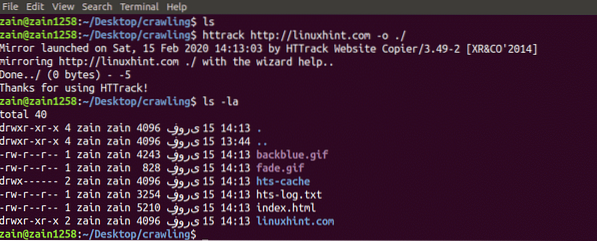

[email protégé] :~$ httrack http://www.astuce linux.com -o ./La commande ci-dessus récupère toutes les données du site et les enregistre dans le répertoire actuel. L'image suivante décrit comment utiliser httrack :

Sur la figure, nous pouvons voir que les données du site ont été récupérées et enregistrées dans le répertoire actuel.

Cyotek WebCopie

Cyotek WebCopy est un logiciel d'exploration Web gratuit utilisé pour copier le contenu d'un site Web vers l'hôte local. Après avoir exécuté le programme et fourni le lien du site Web et le dossier de destination, l'ensemble du site sera copié à partir de l'URL donnée et enregistré dans l'hôte local. Télécharger Cyotek WebCopie à partir du lien suivant :

https://www.cyotek.com/cyotek-webcopy/téléchargements

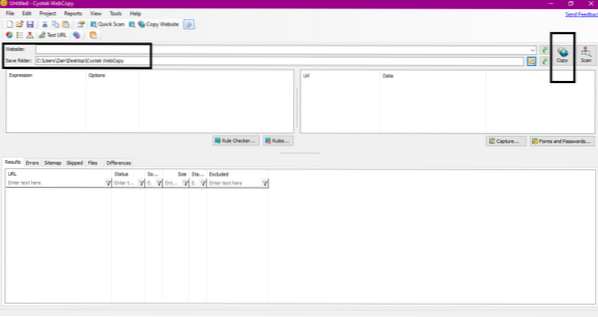

Après l'installation, lorsque le robot d'exploration Web est exécuté, la fenêtre illustrée ci-dessous apparaît :

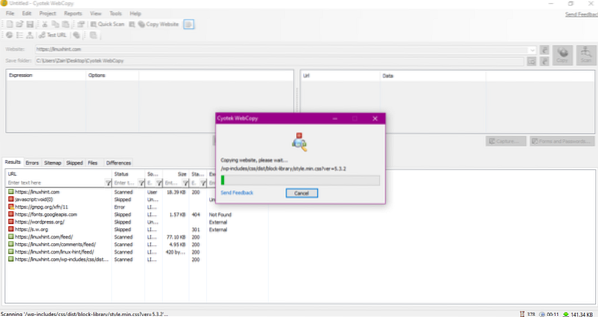

Après avoir entré l'URL du site Web et désigné le dossier de destination dans les champs requis, cliquez sur copier pour commencer à copier les données du site, comme indiqué ci-dessous :

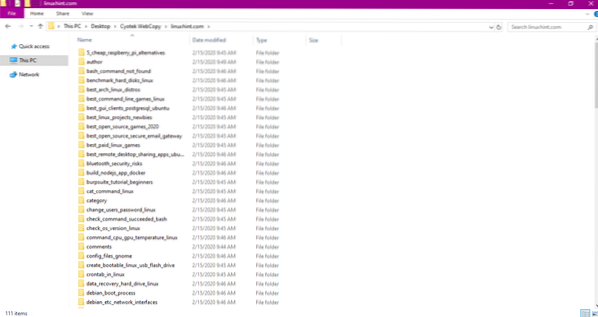

Après avoir copié les données du site Web, vérifiez si les données ont été copiées dans le répertoire de destination comme suit :

Dans l'image ci-dessus, toutes les données du site ont été copiées et enregistrées dans l'emplacement cible.

Saisie de contenu

Content Grabber est un logiciel basé sur le cloud qui est utilisé pour extraire des données d'un site Web. Il peut extraire des données de n'importe quel site Web multi-structure. Vous pouvez télécharger Content Grabber à partir du lien suivant

http://www.tuvaches.com/preview/1601497/Content-Grabber

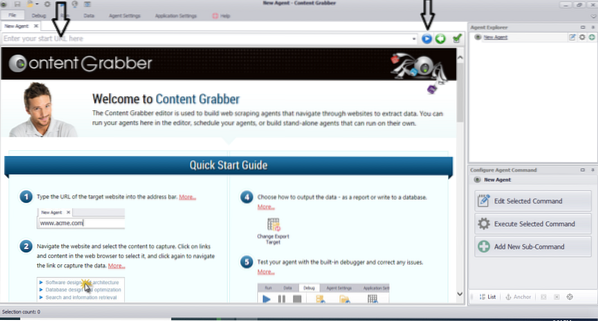

Après avoir installé et exécuté le programme, une fenêtre apparaît, comme illustré dans la figure suivante :

Entrez l'URL du site Web à partir duquel vous souhaitez extraire des données. Après avoir entré l'URL du site Web, sélectionnez l'élément que vous souhaitez copier comme indiqué ci-dessous :

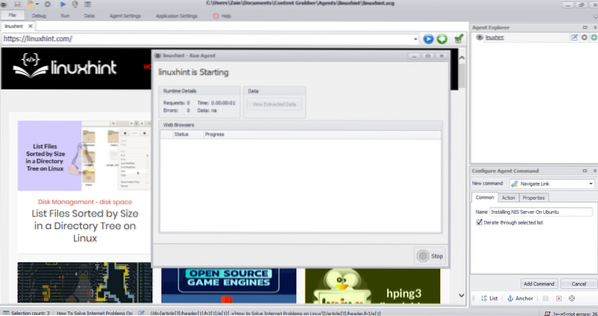

Après avoir sélectionné l'élément requis, commencez à copier les données du site. Cela devrait ressembler à l'image suivante :

Les données extraites d'un site Web seront enregistrées par défaut à l'emplacement suivant :

C:\Users\username\Document\Content GrabberParseHub

ParseHub est un outil d'exploration Web gratuit et facile à utiliser. Ce programme peut copier des images, du texte et d'autres formes de données à partir d'un site Web. Cliquez sur le lien suivant pour télécharger ParseHub :

https://www.parsehub.com/démarrage rapide

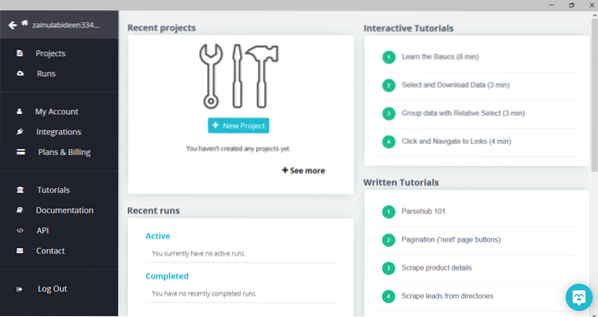

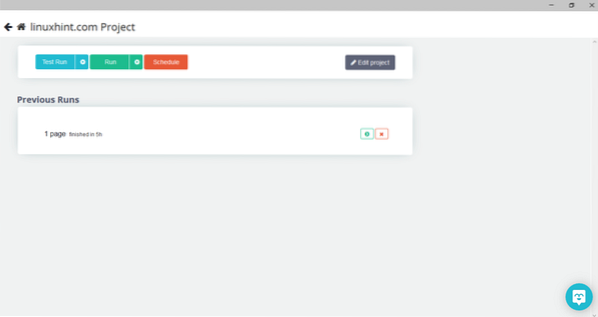

Après avoir téléchargé et installé ParseHub, exécutez le programme. Une fenêtre apparaîtra, comme illustré ci-dessous :

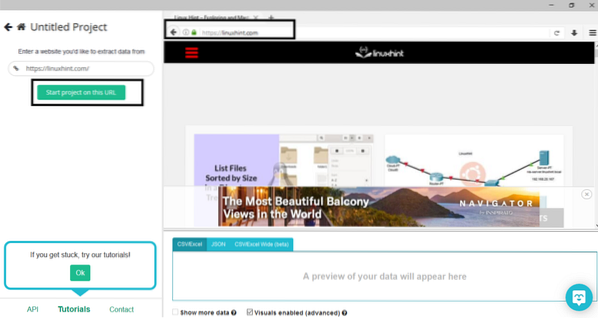

Cliquez sur "Nouveau projet", entrez l'URL dans la barre d'adresse du site Web à partir duquel vous souhaitez extraire des données, et appuyez sur Entrée. Ensuite, cliquez sur "Démarrer le projet sur cette URL."

Après avoir sélectionné la page requise, cliquez sur « Obtenir des données » sur le côté gauche pour parcourir la page Web. La fenêtre suivante apparaîtra :

Cliquez sur « Exécuter » et le programme vous demandera le type de données que vous souhaitez télécharger. Sélectionnez le type requis et le programme demandera le dossier de destination. Enfin, enregistrez les données dans le répertoire de destination.

Hub OutWit

OutWit Hub est un robot d'indexation utilisé pour extraire des données de sites Web. Ce programme peut extraire des images, des liens, des contacts, des données et du texte d'un site Web. Les seules étapes requises sont de saisir l'URL du site Web et de sélectionner le type de données à extraire. Téléchargez ce logiciel à partir du lien suivant :

https://www.déjouer.fr/produits/hub/

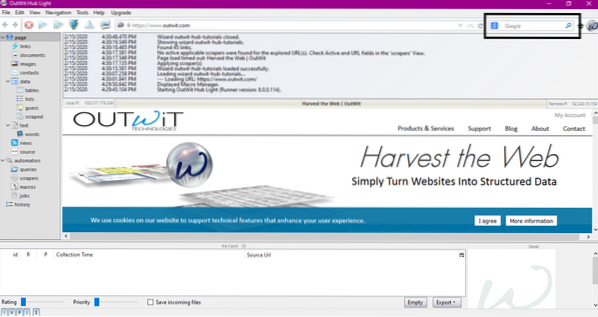

Après avoir installé et exécuté le programme, la fenêtre suivante apparaît :

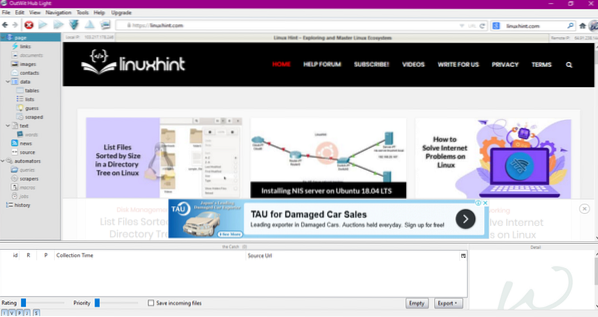

Entrez l'URL du site Web dans le champ indiqué dans l'image ci-dessus et appuyez sur Entrée. La fenêtre affichera le site Web, comme indiqué ci-dessous :

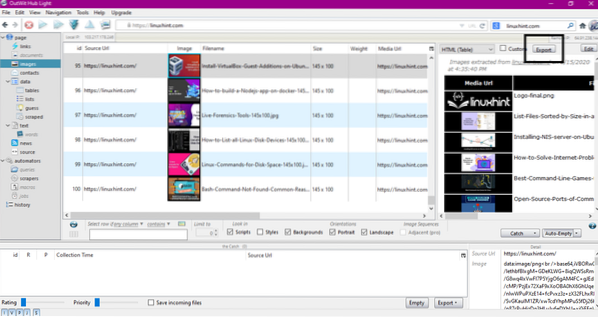

Sélectionnez le type de données que vous souhaitez extraire du site Web dans le panneau de gauche. L'image suivante illustre précisément ce processus :

Maintenant, sélectionnez l'image que vous souhaitez enregistrer sur l'hôte local et cliquez sur le bouton d'exportation marqué dans l'image. Le programme demandera le répertoire de destination et enregistrera les données dans le répertoire.

Conclusion

Les robots d'exploration Web sont utilisés pour extraire des données de sites Web. Cet article traite de certains outils d'exploration Web et de leur utilisation. L'utilisation de chaque robot d'indexation a été discutée étape par étape avec des chiffres si nécessaire. J'espère qu'après avoir lu cet article, vous trouverez facile d'utiliser ces outils pour explorer un site Web.

Phenquestions

Phenquestions